Indholdsfortegnelse:

- Trin 1: Konfigurer en Google Cloud Storage Bucket

- Trin 2: Formater dine data, og opret datasæt Csv

- Trin 3: Upload dine spektrogrammer til din spand

- Trin 4: Upload dit datasæt Csv

- Trin 5: Opret datasæt

- Trin 6: Opret din AutoML -model

- Trin 7: Test din model

- Trin 8: Installer din model i ThinkBioT

Video: Del 2. ThinkBioT -model med Google AutoML: 8 trin

2024 Forfatter: John Day | [email protected]. Sidst ændret: 2024-01-30 08:27

ThinkBioT er designet til at være "Plug and Play" med Edge TPU -kompatible TensorFlow Lite -modeller.

I denne dokumentation dækker vi oprettelse af spektrogrammer, formatering af dine data og brug af Google AutoML.

Koden i denne vejledning vil blive skrevet i bash, så den er kompatibel med flere platforme.

Afhængigheder

- Men inden du begynder, skal du installere Sox et kommandolinjelydprogram, der er kompatibelt med Windows, Mac og Linux -enheder.

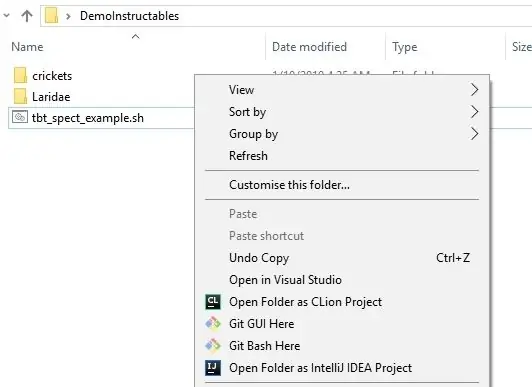

- Hvis du er på en Windows -enhed, er den nemmeste måde at køre bash -scripts på via Git, så jeg vil anbefale og downloade og installere det, da det er nyttigt på mange måder,

- For at redigere kode skal du enten bruge din foretrukne editor eller installere NotePad ++ til Windows eller Atom til andre operativsystemer.

** Hvis du har en eksisterende TensorFlow -model eller vil prøve at overføre læring med en eksisterende model, kan du se i Google Coral Documentation.

Trin 1: Konfigurer en Google Cloud Storage Bucket

1. Log ind på din gmail -konto (eller opret en, hvis du ikke har en Google -konto)

2. Gå til projektvælger -siden, og lav et nyt projekt til dig model- og spektrogramfiler. Du skal aktivere fakturering for at komme videre.

3. Besøg https://cloud.google.com/storage/, og tryk på knappen Opret bucket øverst på siden.

4. Indtast det ønskede spandnavn, og opret den spand, der accepterer standardindstillinger.

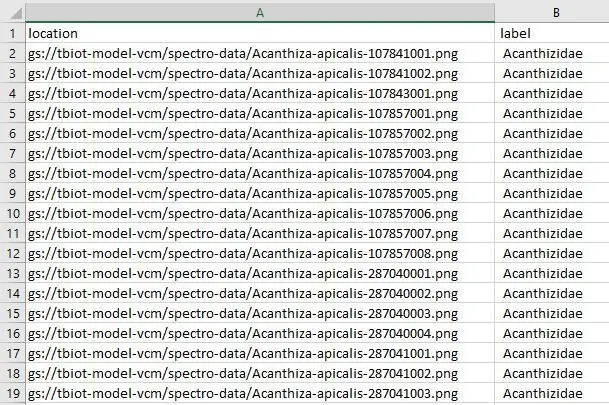

Trin 2: Formater dine data, og opret datasæt Csv

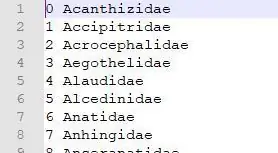

Jeg har designet et nyttigt script til at oprette din dataset.csv -fil, der er nødvendig for at oprette din model. Datasætfilen forbinder billederne i din spand med deres etiketter i datasættet.

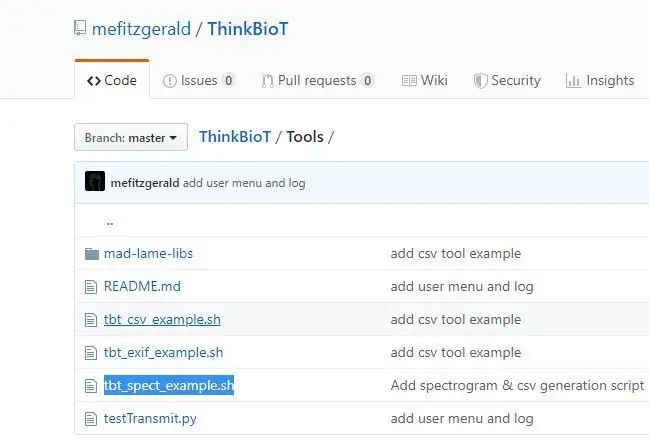

1. Download ThinkBioT -depotet fra GitHub og

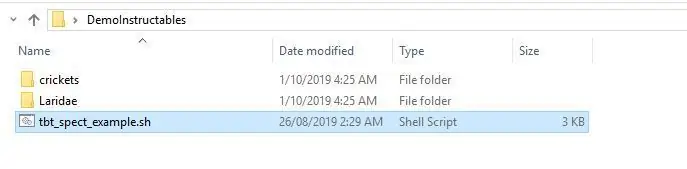

2. Kopier filen tbt_spect_example.sh fra mappen Værktøjer til en ny mappe på dit skrivebord.

3. Tilføj de lydfiler, du gerne vil bruge i din model, og læg dem i mapper, der har deres etiket (dvs. hvad du gerne vil have dem sorteret i. Hvis du f.eks. Ville identificere hunde eller katte, kunne du have en mappe hund, med barklyde ELLER mappe med navnet kat med kattelyde osv.

4. Åbn tbt_spect_example.sh med Notesblok ++, og erstat "dit navn på navn" på linje 54 med navnet på din Google Storage Bucket. For eksempel, hvis din spand blev kaldt myModelBucket, ville linjen blive ændret til

bucket = "gs: // myModelBucket/spectro-data/"

5. Kør koden ved at skrive følgende i din Bash-terminal, koden kører og opretter dine labels csv-fil og et bibliotek kaldet spektrodata på din bordplade med de resulterende spektrogrammer.

sh tbt_spect_example.sh

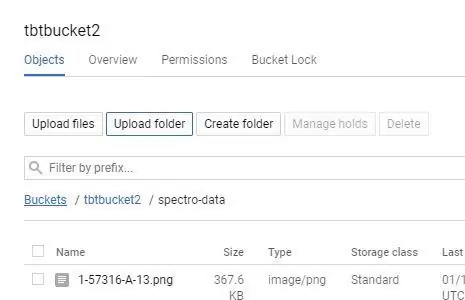

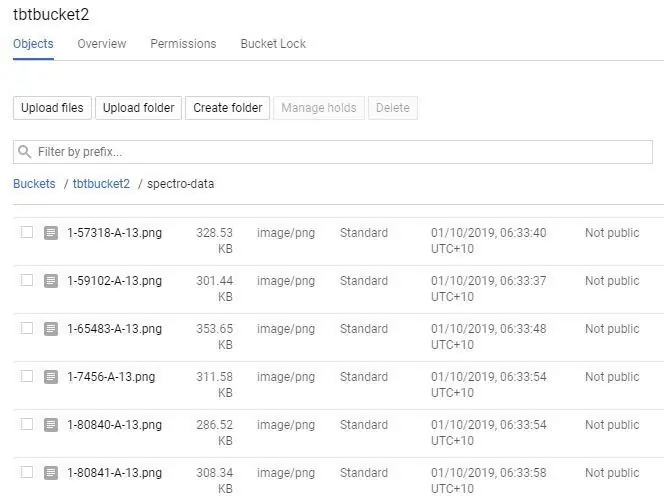

Trin 3: Upload dine spektrogrammer til din spand

Der er et par måder at uploade til Google Storage, den nemmeste er at lave en direkte mappe op load;

1. Klik på dit skovlnavn på din Google Storage -side.

2. Vælg knappen "UPLOAD FOLDER", og vælg dit "spectro-data/" bibliotek, der blev oprettet i det sidste trin.

ELLER

2. Hvis du har en stor mængde filer, kan du manuelt oprette "spectro-data/" biblioteket ved at vælge "Opret mappe", navigere derefter ind i mappen og vælge "UPLOAD FILES". Dette kan være en god mulighed for store datasæt, da du kan uploade spektrogrammerne i sektioner, selv ved at bruge flere computere til at øge uploadhastigheden.

ELLER

2. Hvis du er en avanceret bruger, kan du også uploade via Google Cloud Shell;

gsutil cp spectro-data/* gs: // your-bucket-name/spectro-data/

Du skulle nu have en spand fuld af smukke smukke spektrogrammer!

Trin 4: Upload dit datasæt Csv

Nu skal vi uploade model-labels.csv-filen til dit "spectro-data/" bibliotek i Google Storage, det er stort set det samme som det sidste trin, du uploader bare en enkelt fil i stedet for mange.

1. Klik på dit skovlnavn på din Google Storage -side.

2. Vælg knappen "UPLOAD FILE", og vælg din model-labels.csv-fil, du har oprettet tidligere.

Trin 5: Opret datasæt

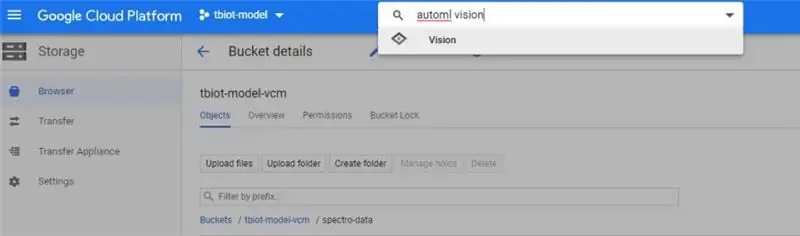

1. For det første skal du finde AutoML VIsion API, det kan være lidt vanskeligt! Den nemmeste måde er at søge efter "automl vision" i søgelinjen i dit Google Cloud -lager (billede).

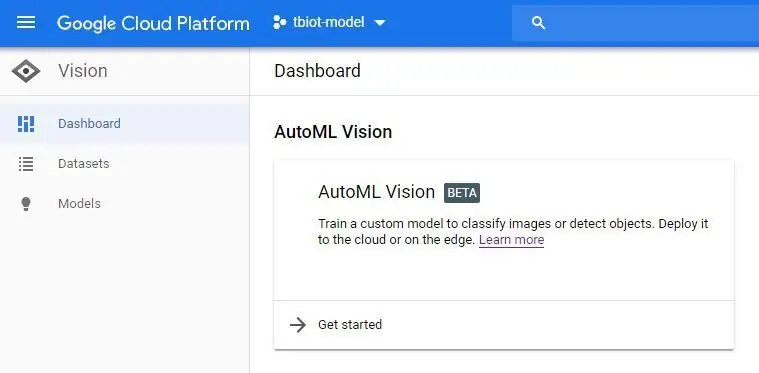

2. Når du klikker på API -linket, skal du aktivere API'en.

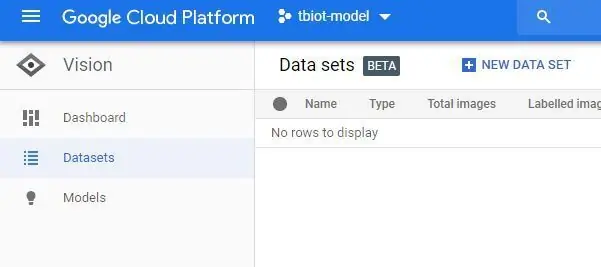

3. Nu vil du være i AutoML Vision Dashboard (billedet) klikke på det nye datasæt -knap og vælge Single label og 'Vælg en CSV -fil'. Du vil derefter inkludere linket til din model-labels.csv-fil i din opbevaringsbucket. Hvis du har fulgt denne vejledning, vil det være som beskrevet nedenfor

gs: //yourBucketName/spectro-data/model-labelsBal.csv

4. Tryk derefter på Fortsæt for at oprette dit datasæt. Det kan tage lidt tid at oprette.

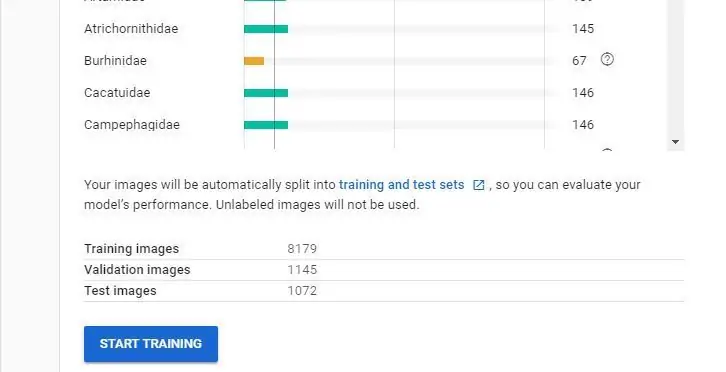

Trin 6: Opret din AutoML -model

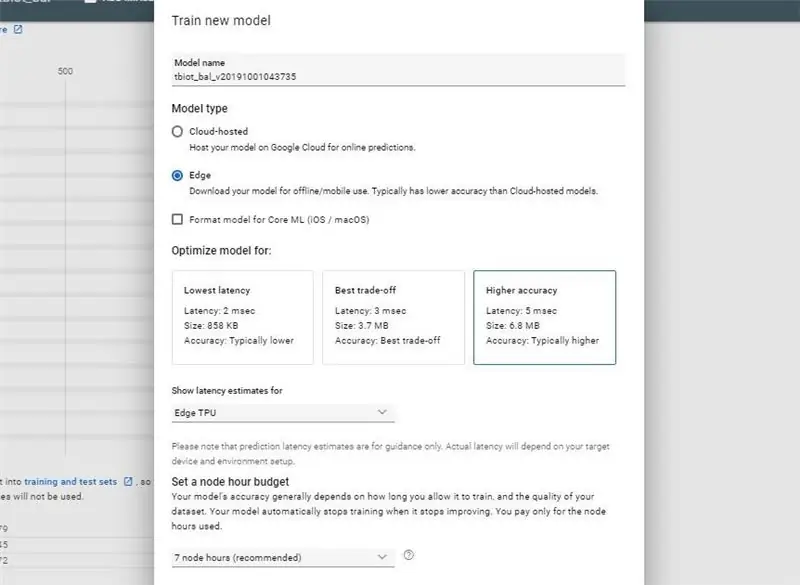

Når du har modtaget din e -mail, der fortæller dig, at dit datasæt er blevet oprettet, er du klar til at oprette din nye model.

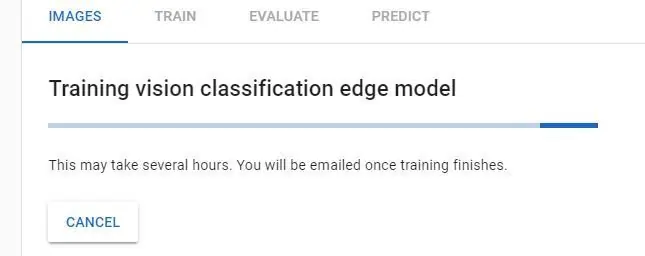

- Tryk på TRAIN -knappen

- Vælg modeltype: Estimater for Edge og Model latency: Edge TPU, og lad de andre muligheder stå som standard i starten, hårde du måske vil eksperimentere med og senere.

- Nu vil din model træne, det vil tage noget tid, og du vil modtage en e -mail, når den er klar til download.

Bemærk: Hvis du træner, er knappen ikke tilgængelig, kan du have problemer med dit datasæt. Hvis du har mindre end 10 af hver klasse (etiket), lader systemet dig ikke træne en model, så du skal muligvis tilføje ekstra billeder. Det er værd at kigge på Google AutoML Video, hvis du har brug for afklaring.

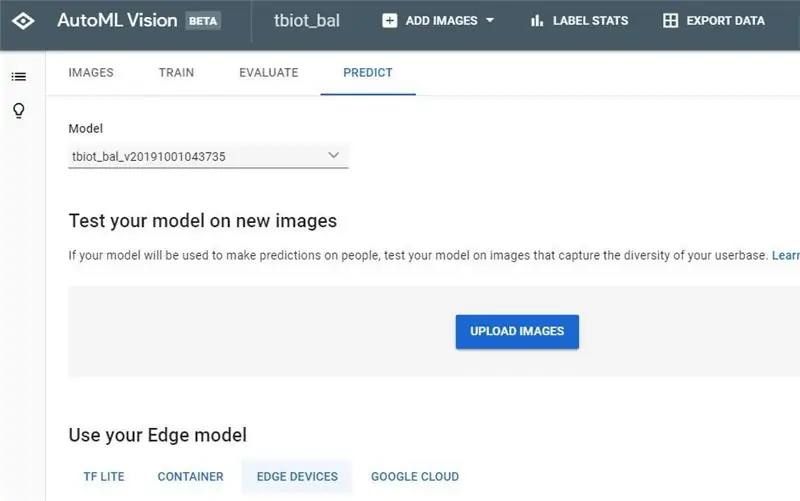

Trin 7: Test din model

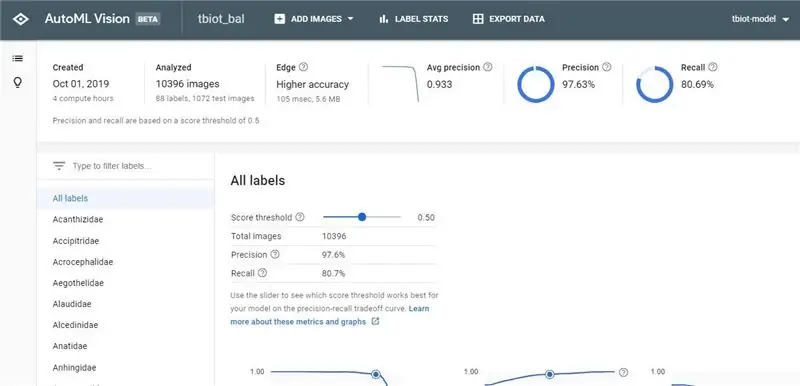

Når du har modtaget din model med færdiggørelse af din model, skal du klikke på linket for at vende tilbage til AutoML Vision API.

1. Nu vil du kunne se dine resultater og forvirringsmatrixen for din model.

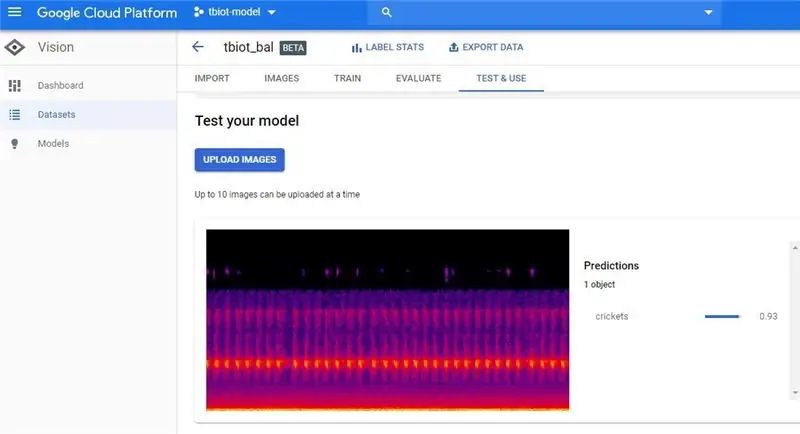

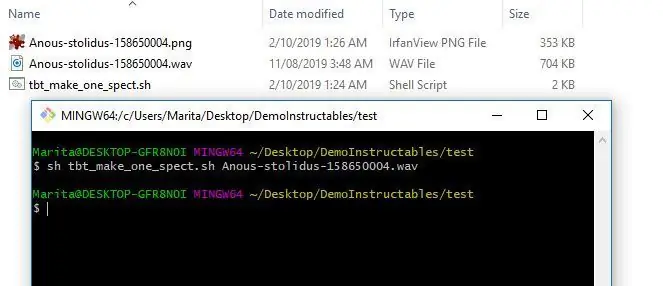

2. Det næste trin er at teste din model, gå til 'TEST & BRUG' eller 'FORudsig' mærkeligt synes der at være 2 bruger -GUI'er, som jeg begge har afbildet, men mulighederne har begge den samme funktionalitet.

3. Nu kan du uploade et testspektrogram. For at lave et enkelt spektrogram kan du bruge programmet tbt_make_one_spect.sh fra ThinkBioT Github. Bare slip det i en mappe med den wav, du vil konvertere til et spektrogram, åbn et Git Bash -vindue (eller terminal) og brug koden herunder og erstat dit filnavn.

sh tbt_make_one_spect.sh yourWavName.wav

4. Upload nu bare spektrogrammet og tjek dit resultat!

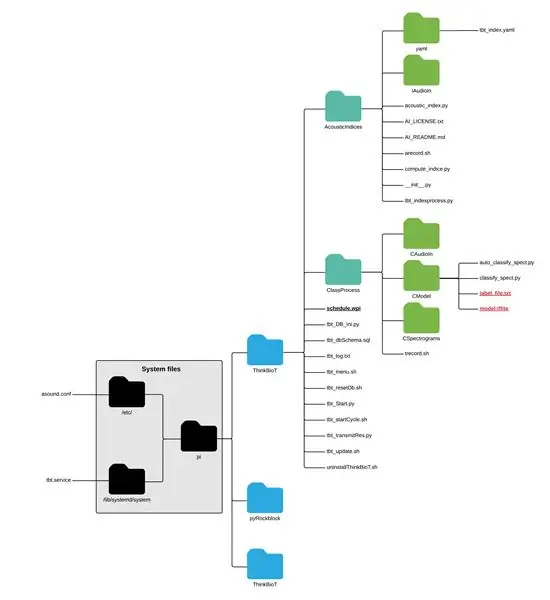

Trin 8: Installer din model i ThinkBioT

For at bruge din nye skinnende model skal du blot droppe modellen og txt -filen i CModel -mappen;

pi> ThinkBioT> ClassProcess> CModel

Nu er du klar til at bruge ThinkBioT:)

** NB ** Hvis du bruger din model uden for ThinkBioT-rammen, skal du redigere dit etiketdokument som tilføjelse til begyndelsen af hver linje, da de nyeste tflite-tolke indbyggede "readlabels" -funktion antager, at de er der. Jeg har skrevet en brugerdefineret funktion i ThinkBioT -rammen classify_spect.py som et arbejde, som du er velkommen til at bruge i din egen kode:)

def ReadLabelFile (file_path):

tæller = 0 med åben (file_path, 'r', encoding = 'utf-8') som f: lines = f.readlines () ret = {} for linje i linjer: ret [int (counter)] = line.strip () tæller = tæller + 1 returret

Anbefalede:

Automatisering af et drivhus med LoRa! (Del 2) -- Motoriseret vinduesåbner: 6 trin (med billeder)

Automatisering af et drivhus med LoRa! (Del 2) || Motoriseret vinduesåbner: I dette projekt vil jeg vise dig, hvordan jeg lavede en motoriseret vinduesåbner til mit drivhus. Det betyder, at jeg vil vise dig, hvilken motor jeg brugte, hvordan jeg designede det egentlige mekaniske system, hvordan jeg kørte motoren og endelig, hvordan jeg brugte en Arduino LoRa

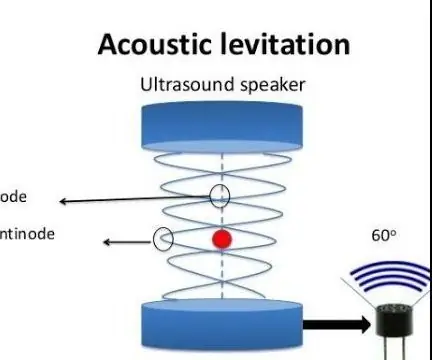

Akustisk levitation med Arduino Uno trin for trin (8 trin): 8 trin

Akustisk levitation med Arduino Uno Step-by Step (8-trin): ultralyds lydtransducere L298N Dc kvindelig adapter strømforsyning med en han-DC-pin Arduino UNOBreadboard Sådan fungerer det: Først uploader du kode til Arduino Uno (det er en mikrokontroller udstyret med digital og analoge porte til konvertering af kode (C ++)

Del 1. ThinkBioT Autonomous Bio-akustisk Sensor Hardware Hardware: 13 trin

Del 1. ThinkBioT Autonomous Bio-acoustic Sensor Hardware Build: ThinkBioT sigter mod at levere en software- og hardware-ramme, der er designet som en teknologisk rygrad til at understøtte yderligere forskning, ved at håndtere detaljer om dataindsamling, forbehandling, dataoverførsel og visualiseringsopgaver, der muliggør forsker

Del WiFi med Ethernet -port på en Raspberry Pi: 7 trin (med billeder)

Del WiFi med Ethernet -port på en Raspberry Pi: Har du en gammel laserprinter eller scanner, der stadig fungerer godt, men ikke er wifi -kompatibel? Eller måske vil du tilslutte en ekstern harddisk som en backupenhed på dit netværk, og du er løbet tør for ethernet -porte på din hjemmrouter. Denne instr

Brug af AC med lysdioder (del 4) - de nye teknologier: 6 trin (med billeder)

Brug af AC med lysdioder (del 4) - de nye teknologier: Nogle af vejspærringerne i almindelig accept af LED i hjemmet har været den relative høje pris pr. Lumen og de komplicerede og klodsede strømkonverteringssystemer. I de seneste måneder lover en række nye udviklinger at bringe os et skridt tættere på