Indholdsfortegnelse:

- Trin 1: Oversigt over projektet

- Trin 2: Baggrundsforskning

- Trin 3: Designkrav

- Trin 4: Teknisk design og valg af udstyr

- Trin 5: Valg af udstyr: Metode til interaktion

- Trin 6: Valg af udstyr: Mikrocontroller

- Trin 7: Valg af udstyr: Sensorer

- Trin 8: Valg af udstyr: Software

- Trin 9: Valg af udstyr: Andre dele

- Trin 10: Systemudvikling: Oprettelse af hardware del 1

- Trin 11: Systemudvikling: Oprettelse af hardware del 2

- Trin 12: Systemudvikling: Programmering af systemdel 1

Video: Cane-eye: Se med dine ører: 16 trin (med billeder)

2024 Forfatter: John Day | [email protected]. Sidst ændret: 2024-01-30 08:29

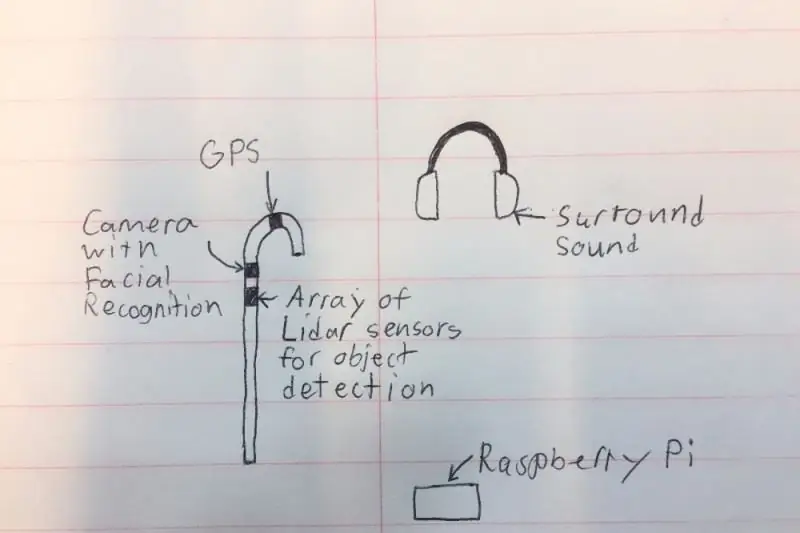

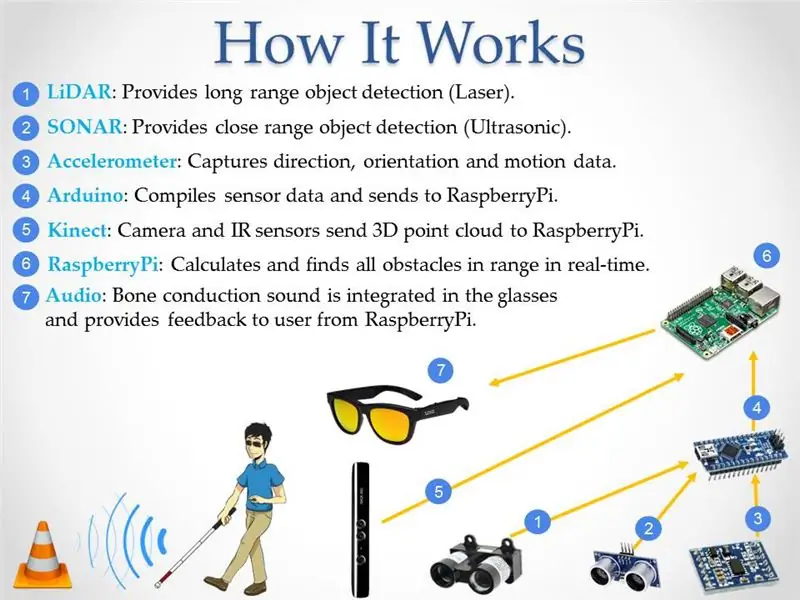

Jeg vil skabe en intelligent 'stok', der kan hjælpe mennesker med synshandicap meget mere end eksisterende løsninger. Stokken vil kunne underrette brugeren om genstande foran eller på siderne ved at lave en støj i surroundhovedtelefonerne. Stokken vil også have et lille kamera og LIDAR (Light Detection and Ranging), så den kan genkende objekter og mennesker i rummet og underrette brugeren ved hjælp af hovedtelefonerne. Af sikkerhedsmæssige årsager blokerer hovedtelefonerne ikke al støj, da der vil være en mikrofon, der kan filtrere alle unødvendige lyde ud og holde bilens horn og folk i tale. Endelig vil systemet have en GPS, så det kan give retninger og vise brugeren, hvor han skal hen.

Stem venligst på mig i Arduino- og Raspberry Pi -konkurrencerne!

Trin 1: Oversigt over projektet

Ifølge World Access for the Blind er fysisk bevægelse en af de største udfordringer for blinde. At rejse eller bare gå ned ad en overfyldt gade kan være meget vanskelig. Traditionelt var den eneste løsning at bruge den almindeligt kendte "hvide stok", som primært bruges til at scanne omgivelser ved at ramme forhindringerne i nærheden af brugeren. En bedre løsning ville være en enhed, der kan erstatte den synlige assistent ved at give oplysninger om placeringen af forhindringer, så den blinde person kan gå ud i ukendte miljøer og føle sig tryg. Under dette projekt blev der udviklet en lille batteridrevet enhed, der opfylder disse kriterier. Enheden kan registrere objektets størrelse og placering ved hjælp af sensorer, der måler objekternes position i forhold til brugeren, videresender disse oplysninger til en mikrokontroller og derefter konverterer den til lyd for at give information til brugeren. Enheden blev bygget ved hjælp af tilgængelig kommerciel LIDAR (Light Detection and Ranging), SONAR (Sound Navigation and Ranging) og computervisionsteknologier, der er knyttet til mikrokontroller og programmeret til at levere den nødvendige hørbare informationsoutput ved hjælp af øretelefoner eller hovedtelefoner. Detektionsteknologien var integreret i en "hvid stok" for at angive brugerens tilstand for andre og give yderligere sikkerhed.

Trin 2: Baggrundsforskning

I 2017 rapporterede Verdenssundhedsorganisationen, at der på verdensplan var 285 millioner synshæmmede, hvoraf 39 millioner er helt blinde. De fleste mennesker tænker ikke over de problemer, synshandicappede står over for hver dag. Ifølge World Access for the Blind er fysisk bevægelse en af de største udfordringer for blinde. At rejse eller bare gå ned ad en overfyldt gade kan være meget vanskelig. På grund af dette foretrækker mange synshæmmede at bringe en seende ven eller et familiemedlem til at hjælpe med at navigere i nye miljøer. Traditionelt var den eneste løsning at bruge den almindeligt kendte "hvide stok", som primært bruges til at scanne omgivelser ved at ramme forhindringerne i nærheden af brugeren. En bedre løsning ville være en enhed, der kan erstatte den synlige assistent ved at give oplysninger om placeringen af forhindringer, så den blinde person kan gå ud i ukendte miljøer og føle sig tryg. NavCog, et samarbejde mellem IBM og Carnegie Mellon University, har forsøgt at løse problemet ved at oprette et system, der bruger Bluetooth -beacons og smartphones til at hjælpe med at guide. Løsningen var imidlertid besværlig og viste sig at være meget dyr for store implementeringer. Min løsning adresserer dette ved at eliminere ethvert behov for eksterne enheder og ved at bruge en stemme til at guide brugeren hele dagen (figur 3). Fordelen ved at have teknologien indlejret i en "hvid stok" er, at den signalerer resten af verden af brugerens tilstand, hvilket forårsager ændringer i adfærden hos de omgivende mennesker.

Trin 3: Designkrav

Efter at have undersøgt de tilgængelige teknologier diskuterede jeg mulige løsninger med visionprofessionelle om den bedste tilgang til at hjælpe svagsynede med at navigere i deres miljø. Tabellen nedenfor viser de vigtigste funktioner, der kræves for, at nogen kan overgå til min enhed.

Funktion - Beskrivelse:

- Beregning- Systemet skal levere en hurtig behandling af den udvekslede information mellem brugeren og sensorerne. For eksempel skal systemet være i stand til at informere brugeren om forhindringer foran, der er mindst 2 m væk.

- Dækning - Systemet skal levere sine tjenester indendørs og udendørs for at forbedre kvaliteten af synshandicappede menneskers liv.

- Tid - Systemet skal fungere lige så godt i dagtimerne som om natten.

- Område - Området er afstanden mellem brugeren og det objekt, der skal registreres af systemet. Den ideelle minimumsafstand er 0,5 m, mens den maksimale rækkevidde bør være mere end 5 m. Yderligere afstande ville være endnu bedre, men mere udfordrende at beregne.

- Objekttype - Systemet skal registrere pludselig udseende af objekter. Systemet skal være i stand til at se forskel på objekter i bevægelse og statiske objekter.

Trin 4: Teknisk design og valg af udstyr

Efter at have set på mange forskellige komponenter, besluttede jeg mig for dele valgt fra de forskellige kategorier herunder.

Pris på udvalgte dele:

- Zungle Panther: $ 149,99

- LiDAR Lite V3: $ 149,99

- LV-MaxSonar-EZ1: $ 29,95

- Ultralydssensor - HC -SR04: $ 3,95

- Raspberry Pi 3: $ 39,95

- Arduino: $ 24,95

- Kinect: $ 32,44

- Floureon 11.1v 3s 1500mAh: $ 19,99

- LM2596HV: $ 9,64

Trin 5: Valg af udstyr: Metode til interaktion

Jeg besluttede at bruge stemmestyring som metode til at interagere med enheden, fordi det kan være udfordrende at have flere knapper på en stok for en svagsynet person, især hvis nogle funktioner krævede en kombination af knapper. Med stemmestyring kan brugeren bruge forudindstillede kommandoer til at kommunikere med stokken, hvilket reducerer potentielle fejl.

Enhed: Fordele --- Ulemper:

- Knapper: Ingen kommandofejl, når der trykkes på højre knap --- Det kan være udfordrende at sikre, at der trykkes på de korrekte knapper

- Stemmestyring: Let, fordi brugeren kan bruge forudindstillede kommandoer --- Forkert udtale kan forårsage fejl

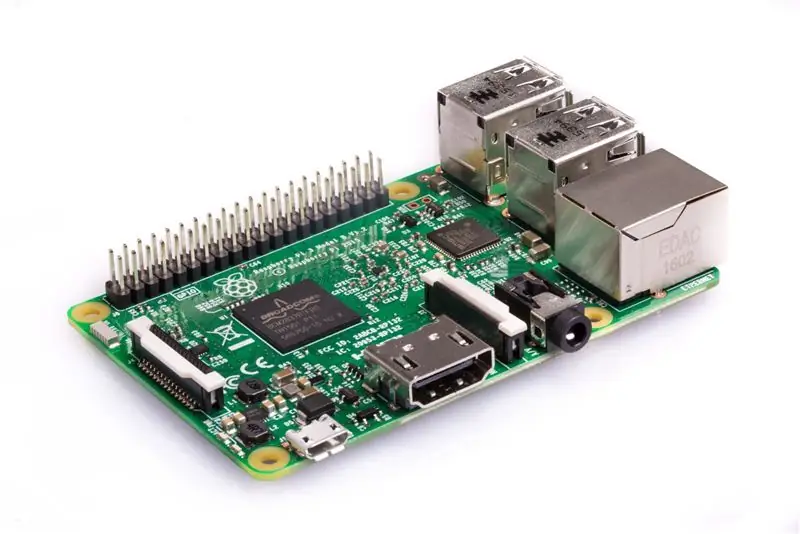

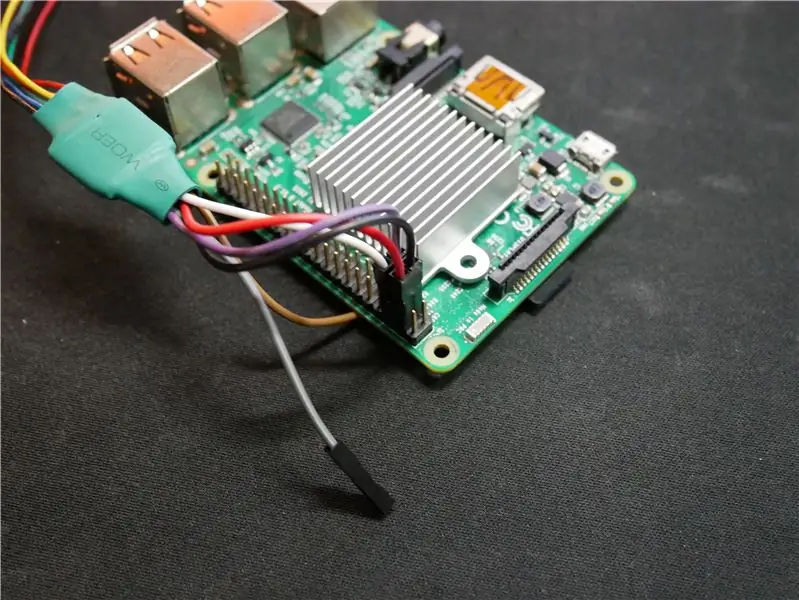

Trin 6: Valg af udstyr: Mikrocontroller

Enheden brugte Raspberry Pi på grund af dens lave omkostninger og tilstrækkelig behandlingskraft til at beregne dybdekortet. Intel Joule ville have været den foretrukne mulighed, men prisen ville have fordoblet omkostningerne ved systemet, hvilket ikke ville være ideelt denne enhed, der er udviklet til at give brugerne en lavere omkostningsmulighed. Arduinoen blev brugt i systemet, fordi den let kan få information fra sensorer. BeagleBone og Intel Edison blev ikke brugt på grund af lavt forhold mellem pris og ydelse, hvilket er dårligt for dette system til lave omkostninger.

Mikrocontroller: Fordele --- Ulemper:

- Raspberry Pi: Har nok processorkraft til at finde forhindringer og har integreret wifi/bluetooth --- Ikke mange muligheder for at modtage data fra sensorer

- Arduino: Modtag let data fra små sensorer. dvs. LIDAR, ultralyd, SONAR osv. --- Ikke nok processorkraft til at finde forhindringer

- Intel Edison: Kan behandle forhindringer hurtigt med hurtig processor --- Kræver ekstra udviklerstykker for at fungere til systemet

- Intel Joule: Har til dato dobbelt behandlingshastighed for nogen af mikrokontrollerne på forbrugermarkedet --- Meget høje omkostninger for dette system og svært at interagere med GPIO til sensorinteraktion

- BeagleBone Black: Kompakt og kompatibel med sensorer, der bruges i projektet ved hjælp af General Purpose Input Output (GPIO) --- Ikke nok processorkraft til effektivt at finde objekter

Trin 7: Valg af udstyr: Sensorer

En kombination af flere sensorer bruges for at opnå høj lokalitetsnøjagtighed. Kinect er hovedsensoren på grund af den mængde areal, den kan scanne efter forhindringer på én gang. LIDAR, der står for Lightt Detection and Ranging, er en fjernføleringsmetode, der bruger lys i form af en pulserende laser til hurtigt at måle afstande fra, hvor sensoren er til objekter; denne sensor bruges, fordi den kan spore et område op til 40 meter (m) væk, og da den kan scanne i forskellige vinkler, kan den registrere, om der går trin op eller ned. SOUND Navigation And Ranging (SONAR) og ultralydssensorer bruges som backup -sporing i tilfælde af at Kinect går glip af en stang eller stød i jorden, der kan udgøre en fare for brugeren. Sensoren 9 Degrees of Freedom bruges til at spore, hvilken retning brugeren vender, så enheden kan gemme oplysningerne med større nøjagtighed, når personen går samme sted.

Sensorer: Fordele --- Ulemper:

- Kinect V1: Kan spore 3D-objekter med --- Kun et kamera til at registrere omgivelser

- Kinect V2: Har 3 infrarøde kameraer og et rødt, grønt, blåt, dybde (RGB-D) kamera til høj præcision 3D-objektdetektering --- Kan varme op og kan have brug for en køleventilator og er større end andre sensorer

- LIDAR: Bjælke, der kan spore steder op til 40 m væk --- Skal placeres mod objektet og kan kun se i den retning

- SONAR: Bjælke, der kan spore 5 m væk, men i en lang afstand --- Små genstande som fjer kan udløse sensoren

- Ultralyd: Har en rækkevidde på op til 3 m og er meget billig --- Afstande kan lejlighedsvis være unøjagtige 9

- Frihedsgrader: God til at registrere brugerens orientering og hastighed --- Hvis noget forstyrrer sensorerne, kan afstandsberegningerne beregnes forkert

Trin 8: Valg af udstyr: Software

Den valgte software til de første få prototyper bygget med Kinect V1 -sensoren var Freenect, men den var ikke særlig præcis. Ved skift til Kinect V2 og Freenect2 blev sporingsresultaterne forbedret betydeligt på grund af forbedret sporing, da V2 har et HD -kamera og 3 infrarøde kameraer i modsætning til et enkelt kamera på Kinect V1. Da jeg brugte OpenNi2 med Kinect V1, var funktionerne begrænsede, og jeg kunne ikke styre nogle af enhedens funktioner.

Software: Fordele --- Ulemper:

- Freenect: Har et lavere kontrolniveau til styring af alt --- Understøtter kun Kinect V1

- OpenNi2: Kan let oprette point cloud-data fra informationsstrømmen fra Kinect --- Understøtter kun Kinect V1 og har ikke understøttelse af lavt niveau kontrol

- Freenect2: Har et lavere kontrolniveau for sensorbjælke --- Fungerer kun til Kinect V2

- ROS: Operativsystem ideelt til programmering af kamerafunktioner --- Skal installeres på et hurtigt SD-kort, så softwaren fungerer

Trin 9: Valg af udstyr: Andre dele

Litiumionbatterier blev valgt på grund af at de var lette, havde en høj strømkapacitet og var genopladelige. 18650 -varianten af litiumionbatteriet har en cylindrisk form og passer perfekt ind i stokprototypen. Den første prototype stok er lavet af PVC -rør, fordi den er hul og reducerer vægten af stokken.

Trin 10: Systemudvikling: Oprettelse af hardware del 1

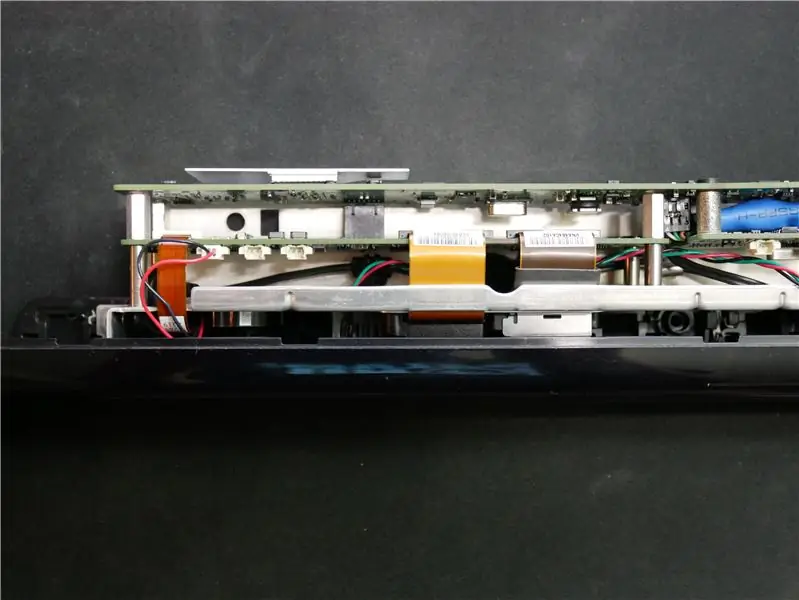

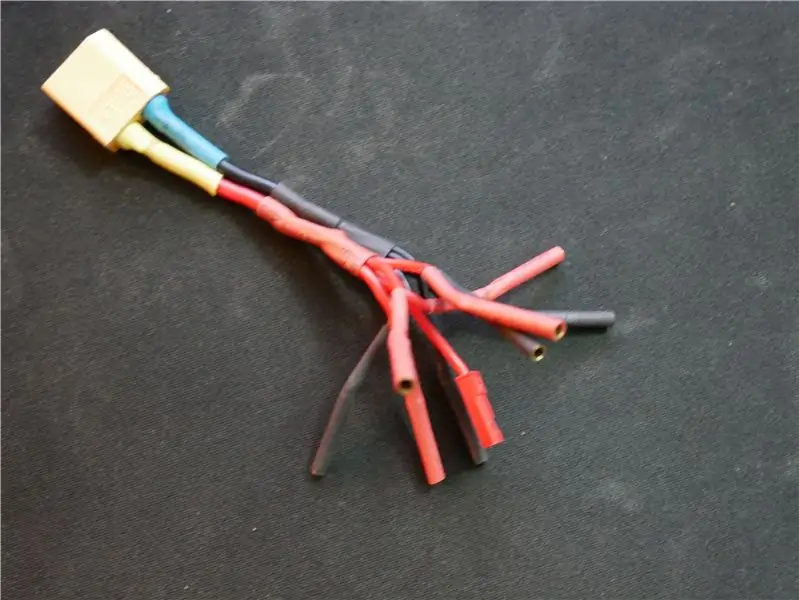

Først skal vi skille Kinect ad for at gøre det lettere og så det passer ind i stokken. Jeg startede med at fjerne alt det ydre kabinet fra Kinect, da den anvendte plast vejer meget. Så måtte jeg skære kablet, så basen kunne fjernes. Jeg tog ledningerne fra stikket vist på billedet og loddet dem til et usb -kabel med signaltråde, og de to andre forbindelser var til 12V indgangseffekt. Da jeg ville have blæseren inde i sukkerrøret til at køre med fuld effekt for at afkøle alle de andre komponenter, skar jeg stikket af blæseren fra Kinect og tilsluttede 5V fra Raspberry Pi. Jeg lavede også en lille adapter til LiDAR -ledningen, så den kan forbindes direkte til Raspberry Pi uden andre systemer imellem.

Jeg lod ved et uheld lod den hvide ledning til den sorte, så se ikke på billederne for ledningsdiagrammer

Trin 11: Systemudvikling: Oprettelse af hardware del 2

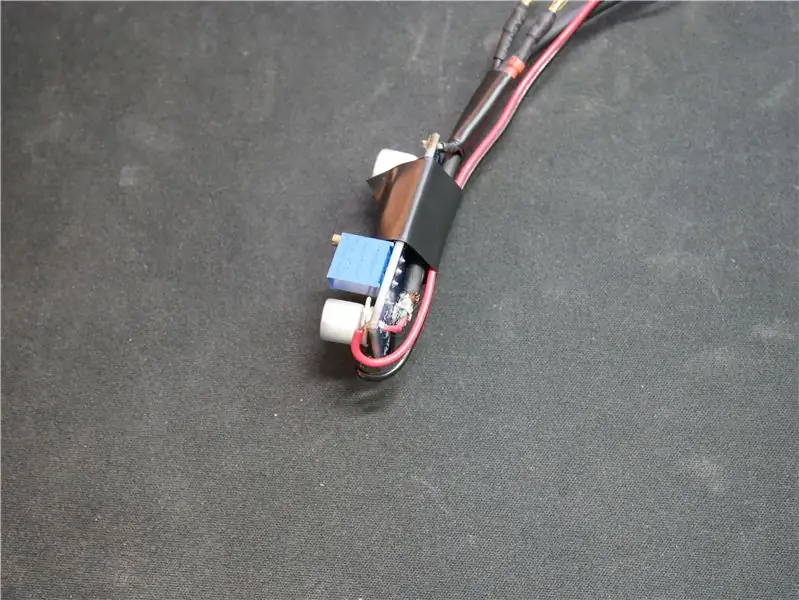

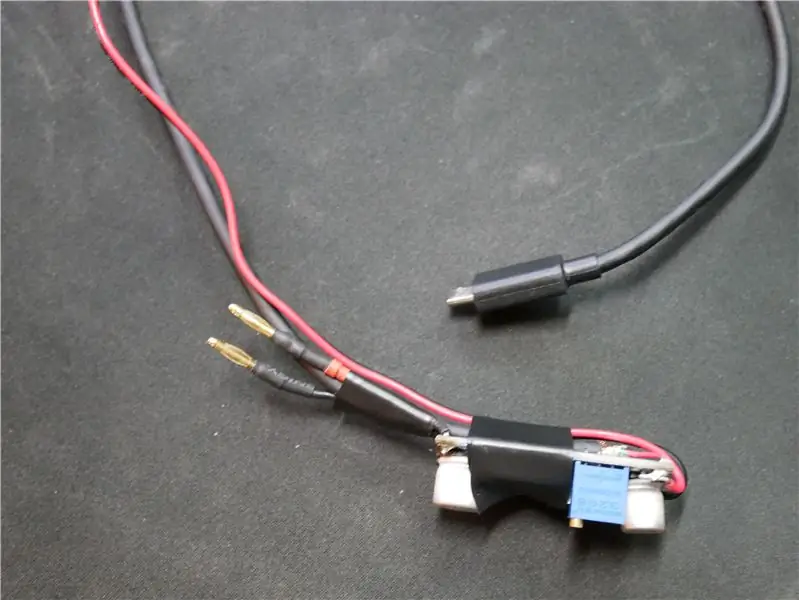

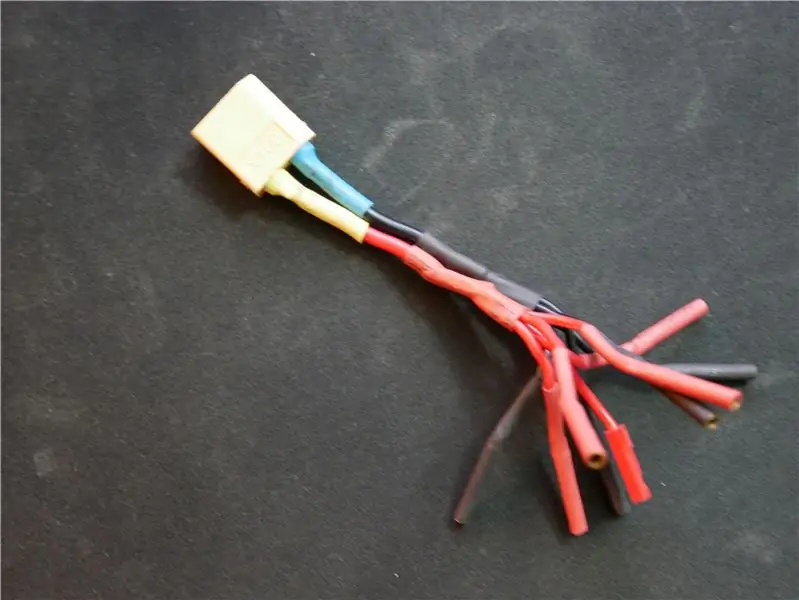

Jeg skabte et regulatorstykke til at levere strøm til alle de enheder, der kræver 5V som Raspberry Pi. Jeg stemte regulatoren ved at sætte en måler på output og justere modstanden, så regulatoren ville levere 5,05V. Jeg satte det lidt højere end 5V, fordi batteriets spænding over tid falder og påvirker udgangsspændingen lidt. Jeg lavede også en adapter, som giver mig mulighed for at drive op til 5 enheder, der kræver 12V fra batteriet.

Trin 12: Systemudvikling: Programmering af systemdel 1

Storpris i stemmeaktiveret udfordring

Anbefalede:

Enkel gestusstyring - Styr dine RC -legetøj med armens bevægelse: 4 trin (med billeder)

Enkel gestusstyring - Styr dine RC -legetøj med armens bevægelse: Velkommen til min 'ible' #45. For et stykke tid siden lavede jeg en fuldt fungerende RC-version af BB8 ved hjælp af Lego Star Wars-dele … https://www.instructables.com/id/Whats-Inside-My-R…Da jeg så, hvor sejt det var Force Band lavet af Sphero, tænkte jeg: "Ok, jeg kan

Styr dine lysdioder med din tv -fjernbetjening ?! -- Arduino IR -tutorial: 5 trin (med billeder)

Styr dine lysdioder med din tv -fjernbetjening ?! || Arduino IR Tutorial: I dette projekt vil jeg vise dig, hvordan jeg genanvendte de ubrugelige knapper på min fjernsyns fjernbetjening for at styre lysdioderne bag mit tv. Du kan også bruge denne teknik til at styre alle slags ting med en smule kode -redigering. Jeg vil også tale lidt om teorien

Tilpassede glødende flerfarvede Mickey -ører: 9 trin (med billeder)

Custom Glowing Multicolored Mickey Ears: Jeg ville dele et lille projekt, jeg arbejdede på for min kones og min sidste Disneyland -tur! Hun har disse smukke tilpassede Minnie Mouse ører lavet af blomster og guldtråd, så jeg tænkte, hvorfor skulle jeg ikke lave mine egne Mickey Mouse ører lidt mere magisk

Gemme dine billeder til din opgave: 4 trin (med billeder)

Gemme dine billeder til din opgave: 1. Åbn et nyt Google -dokument, og brug denne side til at beskytte dine billeder. Brug ctrl (kontrol) og " c " nøgle til kopiering.3. Brug ctrl (kontrol) og " v " nøgle til at indsætte

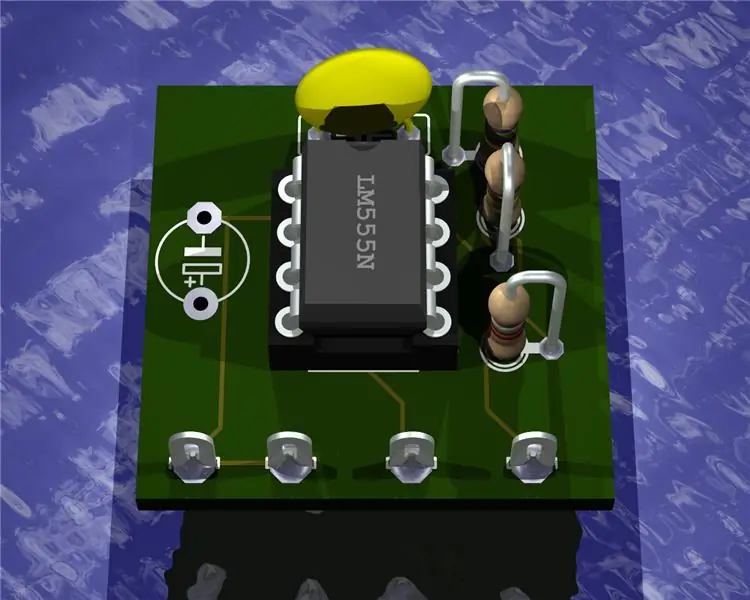

Gengiv 3D-billeder af dine printkort ved hjælp af Eagle3D og POV-Ray: 5 trin (med billeder)

Gengiv 3D-billeder af dine printkort ved hjælp af Eagle3D og POV-Ray: Ved hjælp af Eagle3D og POV-Ray kan du lave realistiske 3D-gengivelser af dine printkort. Eagle3D er et script til EAGLE Layout Editor. Dette vil generere en ray tracing-fil, som vil blive sendt til POV-Ray, som igen til sidst vil poppe ud af den færdige